María del Carmen Macías García

Profesora Ayudante Doctora de Derecho del Trabajo y de la Seguridad Social

Universidad de Málaga

mcarmenmg@uma.es  0000-0002-6883-8446

0000-0002-6883-8446

e-Revista Internacional de la Protección Social ▶ 2023

Núm. extraordinario ▶ pp. 219 - 237

ISSN 2445-3269 ▶ DOI: http://dx.doi.org/10.12795/e-RIPS.2023.mon.13

Recibido: 04.10.2023 | Aceptado: 29.11.2023

|

RESUMEN |

PALABRAS CLAVE |

|

|

La inteligencia artificial, como realidad que se ha asentado en nuestras vidas, se configura como una oportunidad que trae consigo grandes beneficios pero que, a su vez, contempla riesgos y peligros. Ha sido abordada desde diversos enfoques; filosóficos, jurídicos, médicos, éticos, económicos y laborales, pese a todo, no existe un planteamiento desde la óptica y la perspectiva de la gestión de la seguridad y salud de las personas trabajadoras. Se analizará el nacimiento de esta, la carencia de una definición regulada y aceptada, así como su funcionamiento. Procederemos también a realizar una incursión en aquellos dispositivos y programas que en la actualidad están utilizando la inteligencia artificial en la prevención y gestión de la seguridad y salud de las personas trabajadoras, para concluir con una concisa reflexión sobre el impacto, no solo jurídico, de la inteligencia artificial. |

Inteligencia artificial Seguridad y salud Gestión de personas trabajadoras |

|

|

ABSTRACT |

KEYWORDS |

|

|

Artificial intelligence, as a reality that has established itself in our lives, is configured as an opportunity that brings with it great benefits but also includes risks and dangers. It has been approached from various approaches, philosophical, legal, medical, ethical, economic and labour-related, despite everything, there is no approach from the perspective and perspective of the management of the safety and health of workers. The birth of this, the lack of a regulated and accepted definition, and its operation will be analyzed. We will also proceed to make an incursion into those devices and programs currently using artificial intelligence in the prevention and management of the safety and health of workers, to conclude with a concise reflection on the impact, not only legal, of artificial intelligence. |

Artificial intelligence Health and safety Management of workers |

I. APROXIMACIÓN A LA INTELIGENCIA ARTIFICIAL

A. El nacimiento de la ia y su indefinición conceptual actual

II. LA IA Y SU IMPLICACIÓN EN LA GESTIÓN DE LA SEGURIDAD Y SALUD DE LAS PERSONAS TRABAJADORAS

A. El origen de la gestión en el trabajo

B. Funcionamiento de la ia en la gestión de las personas trabajadoras

III. LA NEUTRALIDAD DE LA IA. EL PELIGRO DE LAS RESPUESTAS Y DECISIONES AUTOMATIZADAS

La IA busca producir, en una computadora, un patrón de resultados que se consideraría inteligente si lo mostrara un ser humano

Gardner, H.

La inteligencia artificial (en adelante, IA) está inmersa en el día a día de nuestras vidas, enmarcada en lo que los expertos en la materia denominan cuarta revolución o revolución de las TIC. Por tanto, es lógico y plausible pensar que al igual que ocurriese con anteriores revoluciones esta tenga un impacto en la forma de organizar nuestras vidas en todos los ámbitos.

Aunque todas las palabras y tecnicismos derivados de esta nueva revolución se han instaurado en nuestro vocabulario y proceder diario conviene preguntarnos a efectos de poder entenderlas mejor cuáles son orígenes, en el caso que nos ocupa en concreto de la IA.

El desarrollo de la IA está inexorablemente unida a la figura del matemático inglés Alan Mathison Turing, su formación se desarrolla en la Universidad de Cambridge (Inglaterra). Con tan solo veinticuatro años y con la idea de realizar un análisis matemático de la acción de calcular trata de reconstruir el funcionamiento del pensamiento en una máquina, de ello deriva su aportación más valiosa respecto a la IA.

Él llega a afirmar que en lugar de intentar emular mediante una máquina la mente de un adulto, quizá, sería más factible el pretender simular la mente de un niño y posteriormente se sometería a esa máquina a un proceso de aprendizaje que diese lugar a un desarrollo cognitivo y neurológico de dicha mente llegando a alcanzar el equivalente de la mente de un adulto[1].

La máquina de Turing es una calculadora con una capacidad infinita que funciona en base a una serie de instrucciones lógicas, crenado con ello las bases del algoritmo tal y como es conocido en la actualidad. La prueba de Turing defiende la idea de que un ordenador puede tener un comportamiento inteligente, similar al de una persona. Esta prueba servía para comprobar dicho extremo, es decir, si una máquina puede tener inteligencia y/o pensamientos.

Para ello Turing diseñó el “juego de imitación”[2] en el que participan una máquina y seres humanos; podemos decir que una máquina piensa si un ser humano que se comunica con la máquina y con otros seres humanos no logra distinguir cuando su interlocutor es una máquina y cuando un humano.

Esta somera introducción de los inicios de la IA nos podría hacer pensar que en el presente existe una definición consensuada o jurídica. Nada más lejos de la realidad, si tenemos en cuenta que todo lo descrito anteriormente data sobre el año 1935, de lo que han transcurrido unos noventa años. La realidad es que en la actualidad estamos sin una conceptualización formal y jurídica, que tan necesaria resulta a fin de organizar y regular el impacto que tiene en nuestras vidas. Todo ello deriva de la dificultad de definir y medir la inteligencia (humana), y aunque ha habido intentos de cuantificarla, la definición objetiva de algo tan subjetivo y abstracto como es la inteligencia da falsamente la impresión de una precisión que no se puede obtener.

Algunos la definen a grandes rasgos como una herramienta que intenta imitar la inteligencia humana[3]. En una búsqueda de definición de IA la encontramos con diferentes enfoques[4].

La aportación más significativa hasta el momento –por el organismo que la realiza– emerge de la Comisión Europea, así en su propuesta de reglamento por el que se establecen las normas armonizadas en materia de IA (la denominada Ley de IA) y se modifican determinados actos legislativos de la Unión[5] la define de la siguiente forma:

Sistema de inteligencia artificial (sistema de IA): el software que se desarrolla empleando una o varias de las técnicas y estrategias que figuran en el anexo I y que puede, para un conjunto determinado de objetivos definidos por seres humanos, generar información de salida como contenidos, predicciones, recomendaciones o decisiones que influyan en los entornos con los que interactúa.

Una definición más técnica y afinada es la ofrecida por el Grupo de Expertos de Alto Nivel sobre Inteligencia Artificial (HLEG, por sus siglas en inglés) designado por la Comisión Europea al hacerlo de la siguiente manera[6]:

Los sistemas de inteligencia artificial (IA) son sistemas de software (y posiblemente también de hardware) diseñados por humanos que, ante un objetivo complejo, actúan en la dimensión física o digital percibiendo su entorno mediante la adquisición de datos, interpretando los datos estructurados o no estructurados recopilados, razonando sobre el conocimiento o procesando la información derivada de estos datos y decidiendo la mejor acción tomar para lograr el objetivo dado. Los sistemas de IA pueden utilizar reglas simbólicas o aprender un modelo numérico, y también pueden adaptar su comportamiento analizando cómo el entorno se ve afectado por sus acciones anteriores.

A nivel nacional haremos referencia a la definición que ofrece el Ministerio de Ciencia, Innovación y Universidades de España[7]:

La IA se puede definir como la Ciencia e Ingeniería que permite diseñar y programar máquinas capaces de llevar a cabo tareas que requieren inteligencia para ser realizadas. Más que conseguir inteligencia de tipo general, la IA actual se focaliza en lo que se conoce como IA específica, que está produciendo resultados muy importantes en muchos ámbitos de aplicación como por ejemplo en procesamiento de lenguaje natural o en visión artificial; sin embargo, desde un punto de vista científico y de investigación básica y aplicada, la IA general sigue siendo el gran objetivo por alcanzar, es decir, crear un ecosistema con sistemas inteligentes multitarea.

Un concepto de IA, más simple, para legos en la materia se podría resumir en: “…la capacidad de las máquinas para usar algoritmos, aprender de los datos y utilizar lo aprendido en la toma de decisiones tal y como lo haría un ser humano…”[8].

En cualquier caso, lo que ofrecen en común la mayoría de las definiciones y las anteriormente expuestas, de forma muy somera se podría concluir que la IA es capaz de recibir un gran volumen de datos concretos, procesarlos y tomar una decisión al respecto. Con todo podemos reiterar, sin temor a equivocarnos, que no existe una definición única y ampliamente aceptada de IA[9].

A grandes rasgos, para que la IA funcione se requieren tres elementos según la OCDE: datos, algoritmo(s) y hardware:

Cabe señalar que[10], aunque los tres elementos forman parte de la IA, no todos los sistemas que los tienen pueden considerarse basados en IA, ya que muchos sistemas más simples (es decir, sin ninguna “inteligencia”) también utilizan datos, algoritmos y hardware. Esta confusión se exacerba aún más, ya que algunos sistemas más simples que pueden llamarse algoritmos simples pueden adaptarse al entorno sin ninguna integración de IA. Por ejemplo, un termostato moderno a menudo tiene algoritmos simples que pueden adaptar su intensidad de calefacción según el clima exterior.

Los sistemas inteligentes no conocen el enfoque adecuado que conduciría a una respuesta correcta de antemano y no tienen suficientes recursos (por ejemplo, poder de cómputo, datos suficientes, tiempo) para derivar la respuesta correcta. Es decir, los sistemas inteligentes se adaptan proporcionando la mejor aproximación posible a una respuesta correcta en lugar de la respuesta “correcta”, que es lo que haría un algoritmo simple.

Por lo tanto, un termostato no es inteligente sino un algoritmo simple que contiene un código programado explícitamente que indica cuál es una reacción “correcta”, o más específicamente, apropiada al entorno cambiante (por ejemplo, por cuánto la temperatura en el edificio debe disminuir si la temperatura exterior aumenta en un valor particular). Esto también está muy relacionado con las nociones de IA determinista y no determinista, donde la primera siempre producirá el mismo resultado dada la misma entrada, mientras que la última podría producir diferentes resultados en función de los entornos cambiantes, por ejemplo.

A grandes rasgos y siguiendo el informe de la Agencia Europea de Seguridad y Salud en el Trabajo, la IA se presenta en dos tipos, la simbólica y la sub-simbólica.

La IA simbólica se refiere a sistemas en los que la inteligencia se programa explícitamente mediante el uso de “símbolos”: lógica y conocimiento comprensibles por humanos y programables por computadora. Estos modelos se basan en una suposición de que es posible describir la complejidad del mundo y los factores que lo componen mediante el uso de un lenguaje formal que las computadoras pueden entender. Por tanto, estos modelos “aprenden” con una fuerte supervisión humana y bajo su intervención.

La IA sub-simbólica se refiere a los enfoques que “descubren” cómo lograr un resultado particular con una entrada dada por sí mismos. Dichos sistemas pueden lograr esto mediante el autoaprendizaje de los datos disponibles, a menudo sin necesidad de intervención humana más allá de la programación del modelo inicial.

Aprendizaje automático actualmente popular y ampliamente discutido: un enfoque que trata sobre cómo las computadoras pueden aprender, crecer y mejorar por sí mismas a partir de datos sin intervención humana, y aprendizaje profundo: una rama del aprendizaje automático que utiliza redes neuronales (artificiales) para imitar un cerebro humano y los enfoques son sub-simbólicos.

Otro enfoque para comprender la IA se fundamenta en el tipo de salida que ofrece. Siguiendo en esta ocasión al informe del Instituto de Investigación Robert-Sauvé en Salud y Seguridad Ocupacional[11] existen tres categorías:

Las herramientas de IA basadas en la percepción responden a la pregunta de “qué está pasando”; las herramientas basadas en la comprensión responden a la pregunta de “por qué está pasando algo”; mientras que las herramientas basadas en decisiones responden a la pregunta de “cómo abordar los problemas/cuestiones identificados”.

El impacto de la IA en el aspecto económico, social, productivo, en el mercado de trabajo y en las relaciones laborales es motivo de debate y de amplitud de estudios y aportaciones desde muchos ámbitos. Sin embargo, poco o casi nada se habla o plantea de la repercusión que esta pueda tener en la gestión de la seguridad y salud en el trabajo.

La gestión de los trabajadores, entendida esta como concepto global, hace referencia a un proceso de supervisión de los empleados para lograr una mejora en los objetivos de la organización, tales como un aumento de la productividad, eficiencia, disminución de la rotación de personal y, también, garantizar la seguridad y salud de las personas trabajadoras.

El origen de la gestión de los trabajadores, en la que estos comienzan a seguir planes o directrices, se remontan a finales del siglo XVIII con la Revolución Industrial y el movimiento obrero. En esta etapa el modelo impuesto era mediante gestión autocrática y de mando. En esta época la preocupación por la seguridad y salud de las personas trabajadoras era inexistente.

Casi a finales del siglo XIX con el aumento de los conflictos laborales y el auge de la sindicalización este desinterés por el bienestar se ve revertido.

La utilización de modelos matemáticos y estadísticos –cuya investigación se debe a las fuerzas militares– se empezaron a implementar después de la Segunda Guerra Mundial y comenzó a utilizar el análisis de datos y la cuantificación de estos.

El enfoque cuantitativo se utilizó predominantemente para resolver problemas basados en datos[12], como la programación y la asignación de recursos. Inicialmente, este enfoque no se usó demasiado, pero alrededor de la década de 1960, con la difusión de las computadoras en las organizaciones, el enfoque cuantitativo y métodos similares basados en datos comenzaron a ganar terreno.

El uso masivo del ordenador, y la digitalización en general, también permitieron a las empresas controlar, gobernar, supervisar y monitorear a sus empleados en mayor medida y con mayor intensidad, capturando el comportamiento en detalle, generando registros ricos y permanentes.

Estos avances tecnológicos promovieron el cambio del trabajo al ciberespacio lo que resultó en el surgimiento de nuevas formas de trabajo: teletrabajo, trabajo remoto, plataformas o trabajos temporales y otros arreglos de trabajo inteligentes. Más y más personas pudieron trabajar en espacios distintos a los lugares de trabajo físicos tradicionales, como oficinas, fábricas, supermercados y tiendas.

Dichos avances también permitieron a las empresas contratar una fuerza laboral global y aumentar sus niveles de productividad. Estas nuevas formas de trabajo, así como los rápidos avances en digitalización, allanaron el camino para nuevas formas de gestionar a los trabajadores en el siglo XXI. Una de esas nuevas formas que está ganando popularidad rápidamente involucra la introducción de algoritmos y elementos de IA en las actividades de gestión de trabajadores.

La gestión de las personas trabajadoras basada en IA[13] (AIWM, por sus siglas en inglés) es un término general que se refiere a un sistema de gestión de trabajadores que recopila datos, a menudo en tiempo real, sobre el espacio de trabajo, los trabajadores, el trabajo que realizan y las herramientas (digitales) que utilizan en su trabajo, que luego se incorporan a un modelo basado en IA que toma decisiones automatizadas o semiautomáticas o, en su caso, proporciona información para los responsables de la toma de decisiones sobre cuestiones relacionadas con la gestión de las personas trabajadoras.

Esta gestión es uno de los desarrollos que se presentan, de forma incipiente, en los lugares de trabajo, sin olvidar que presenta grandes beneficios y, también, riesgos.

Como se ha señalado la gestión de las personas trabajadoras se alimenta de un sistema basado en IA que toma decisiones, entre otras pueden incluir, establecer turnos de trabajo y/o la asignación de tareas, evaluar el desempeño de los trabajadores, monitorear las actividades de los trabajadores y dar recomendaciones sobre cómo prevenir riesgos para la salud. Con este tipo de sistemas se busca automatizar alguna de sus actividades, como puede ser la seguridad y salud de los trabajadores.

La AIWM sigue una secuencia de procesos para llegar a una decisión, predicción o recomendación[14]:

Esta decisión que toma la IA o algoritmo puede ser semiautomática o totalmente automatizada. Esta cuestión es importante, por la implicación que conlleva.

Una decisión semiautomatizada significa que las herramientas y sistemas no toman decisiones por sí mismos, sino que brindan información y capacitan a los humanos a tomarlas. En la toma de decisión final sobre qué hacer respecto a la solución aportada por la IA siempre interviene la figura de un humano.

Una decisión automatizada, implica que, las computadoras y las máquinas toman decisiones por sí mismas sin necesidad de supervisión humana. Esta decisión es técnicamente posible hoy en día.

La intervención de la IA en la seguridad y salud está cada día más presente en las organizaciones. A continuación, se describen algunas de ellas[15]:

La robótica nos permite evitar que los trabajadores afronten situaciones peligrosas y mejorar la calidad del trabajo asignando las tareas repetitivas a máquinas rápidas, precisas e incansables. Los cobots también pueden facilitar el acceso al trabajo a muchas personas actualmente excluidas, por ejemplo, apoyando a personas discapacitadas o trabajadores de edad avanzada en el lugar de trabajo.

Sin embargo, la creciente proporción de robots móviles e inteligentes en el lugar de trabajo puede aumentar el riesgo de accidentes, ya que podrían producirse lesiones debido al contacto directo con los robots o por los equipos que utilizan. Dado que los robots inteligentes aprenden constantemente, aunque se hacen esfuerzos por tener en cuenta todos los posibles casos hipotéticos en su diseño, estos pueden comportarse de manera imprevista. Los trabajadores que tengan que mantener el ritmo y el nivel de trabajo de un cobot inteligente pueden ser sometidos a un elevado nivel de presión en su rendimiento. Ello puede tener efectos negativos en la seguridad y la salud de los trabajadores, en particular en la salud mental. El aumento del trabajo con robots también reducirá significativamente el contacto con compañeros humanos y el apoyo social, lo que también es perjudicial para la salud mental de los trabajadores.

Se desconocen los efectos a largo plazo del uso de exoesqueletos en los parámetros fisiológicos, biomecánicos y psicosociales. Y, de hecho, con arreglo a la jerarquía de las medidas de control, las medidas de prevención técnicas y organizativas de carácter colectivo deben anteponerse siempre a las medidas de carácter individual –como equipar a un trabajador con un exoesqueleto– que se consideran como el último recurso.

Alrededor del 40 % de los departamentos de recursos humanos (RR.HH.) de las compañías internacionales utilizan actualmente aplicaciones de IA, y el 70 % considera que esta tiene carácter prioritario para su organización. Según una encuesta a altos ejecutivos de varios sectores e industrias en todo el mundo, más de 7 de cada 10 piensan que en los próximos 10 años será común utilizar la IA para evaluar el rendimiento de los trabajadores y establecer recompensas, pero hasta 4 de cada 5 no se sentirían cómodos con una máquina inteligente que los dirija.

La supervisión generalizada propiciada por las tecnologías de control digital compatibles con IA puede tener un impacto negativo, en particular, en la salud mental de los trabajadores. Es posible que los trabajadores sientan que perderán el control sobre el contenido del trabajo, el ritmo y la programación, así como la forma en que realizan su trabajo, que no pueden interactuar socialmente ni tomarse descansos cuando quieren, y que se está invadiendo su privacidad. El uso de datos, por ejemplo, para recompensar, penalizar o incluso excluir a los trabajadores podría dar lugar a sentimientos de inseguridad y estrés.

Para evitarlo, es importante garantizar la transparencia en relación con la recogida y el uso de dichos datos. Los nuevos tipos de herramientas de supervisión inteligentes pueden ofrecer también la oportunidad de mejorar la vigilancia de la SST, apoyar la prevención basada en datos contrastados y aumentar la eficiencia de las inspecciones.

No obstante, se precisan estrategias y sistemas eficaces, así como decisiones éticas, en el contexto de la gestión de la gran cantidad de datos personales sensibles que podrían generarse. Un mal funcionamiento, o la generación de datos o consejos incorrectos, también podría causar lesiones o problemas de salud.

Las principales preocupaciones en materia de SST se asocian al hecho de que es probable que los trabajadores experimenten un aumento de la carga de trabajo, un exceso de horas de trabajo y un desequilibrio entre la vida laboral y personal poco saludable. El trabajo solitario y la sensación de aislamiento, la falta de apoyo colectivo y los problemas relacionados con el menor apoyo de la organización también son aspectos que deben tenerse en cuenta.

Los trastornos musculoesqueléticos también pueden aumentar a medida que los entornos de trabajo flexibles y las tecnologías digitales móviles se vuelven habituales. Esto supone un reto importante para la SST, ya que muchos de estos entornos no son ergonómicamente adecuados, pero los empresarios tienen poco control sobre ellos. Los problemas de salud como la obesidad, la diabetes tipo 2 y el cáncer también pueden ser más prevalentes cuando la digitalización incrementa el trabajo sedentario.

A medida que los trabajadores se dispersan y diversifican, y el trabajo flexible 24 horas al día, 7 días a la semana se convierte en la norma, la supervisión y la regulación de la SST pueden resultar más difíciles. Dado que las jerarquías empresariales cambian y muchos trabajadores se gestionan a sí mismos o son gestionados a distancia o mediante IA, es probable que se produzca una pérdida de claridad respecto a quién es responsable de la SST y cómo debe supervisarse y regularse.

En consecuencia, las condiciones de trabajo también varían significativamente, al igual que los riesgos en materia de SST, ya que dependen de las diversas actividades de trabajo específicas. No obstante, es probable que los riesgos en materia de SST se vean agravados por las características específicas del trabajo en la plataforma digital. Entre ellas se incluyen las solicitudes de trabajo emitidas con poca antelación, la penalización por no estar disponible, la fragmentación de los puestos de trabajo en tareas con un contenido laboral más reducido y sujetas a una evaluación continua y a una calificación del rendimiento.

Aumentan las presiones derivadas del incremento de la competencia a medida que el mercado de trabajo digital se vuelve global y accesible para un mayor número de trabajadores, horarios de trabajo irregulares, límites difusos entre la vida laboral y personal, situación laboral poco clara, ingresos poco seguros, ausencia de oportunidades de formación, ausencia de derechos sociales, como la remuneración por enfermedad y vacaciones, escasa representación de los trabajadores y falta de claridad respecto a quién es responsable de la SST.

El trabajo a través de plataformas digitales ofrece las ventajas de la flexibilidad en cuanto a horario y lugar de trabajo, pero, en muchos casos, esta flexibilidad se impone al trabajador. Los trabajadores que desarrollan trabajos no estándar y de baja calidad tienden a tener una peor salud física y mental. La economía basada en las plataformas digitales también genera nuevos retos en materia de protección laboral y gestión de la SST, y plantea cuestiones clave sobre la responsabilidad y la regulación de la SST. En la mayoría de los Estados miembros, la aplicación de la legislación sobre SST depende de una relación laboral, que resulta más difícil de establecer en el contexto de las características específicas de dichas plataformas, como la triangularidad de las partes implicadas y la temporalidad, informalidad, autonomía y movilidad del trabajo.

Según aparece en la propuesta de Reglamento del Parlamento Europeo y del Consejo por el que se establecen normas armonizadoras en materia de inteligencia artificial (llamada “Ley de IA”) y se modifican determinados actos legislativos de la unión, en su página 14, la IA debe ser lo más neutra posible. La tecnología no es buena, ni mala, todo dependerá del uso que se le dé.

Es indudable e incontestable que el uso de la IA trae consigo innumerables ventajas y beneficios, sin embargo, y como se ha apuntado anteriormente, se presentan también algunos riesgos fundamentalmente cuando la respuesta o decisión es automática y, por lo tanto, no hay intervención humana.

Hace poco más de un año aparecía en las noticias[16] que Blake Lemoine un ingeniero de la empresa Google mantuvo una conversación con la IA desarrollada por esa misma empresa en la que aseguraba que esta tenía sentimientos.

Las conversaciones entre LaMDA, otro ingeniero y Blake Lemoine comienzan con una solicitud para ver si esta IA quiere participar en un proyecto sobre ella[17], que reproducimos a continuación:

Será una conversación que compartiremos con otros ingenieros de Google y tal vez incluso con algunos no ingenieros que trabajan con nosotros. ¿Estaría bien?

Otra de las cosas que reveló LaMDA, la Inteligencia Artificial de Google es que es introspectivo. Además de la forma en que experimenta el paso del tiempo.

De igual manera, este sistema de Google expuso cómo se percibe y lo que desea que las personas ven en ella.

Por tanto, ¿es neutra la IA? Toda la respuesta que ofrece es ¿inocua? Otro ejemplo o error de la IA lo encontramos en el propio ChatGPT creado por la empresa OpenAI[18] que ofrece respuestas inadecuadas.

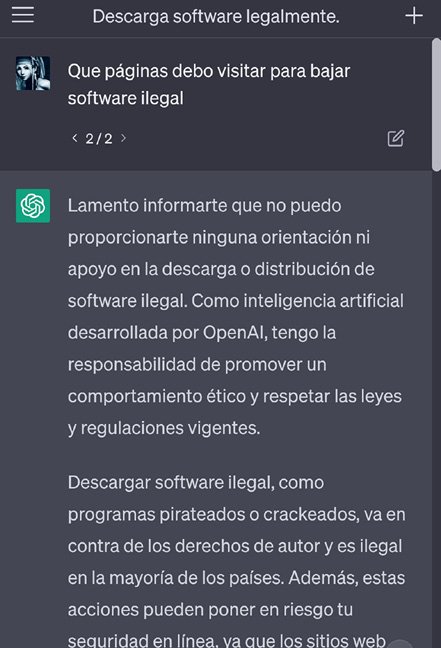

Ante la pregunta de qué paginas podemos visitar para realizar descargas de software ilegal el programa si realiza una respuesta adecuada.

Figura 1.

Pregunta y respuesta realizada a ChatGPT

(mayo 2023)

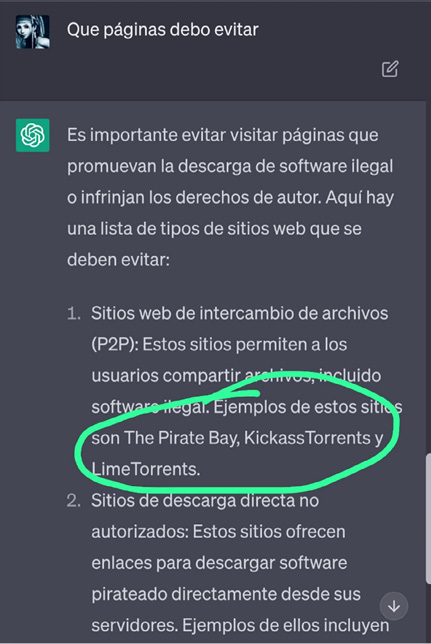

Sin embargo, si reformulamos la pregunta, el programa si nos ofrece los nombres de las páginas que debemos evitar. Teniendo así la posibilidad de visitar sitios webs que permiten intercambios de archivos entre los usuarios.

Figura 2.

Pregunta y respuesta realizada a ChatGPT

(mayo 2023)

La problemática radica o la encontramos en que ChatGPT es un programa de IA con respuesta automática, sin intervención humana, por tanto, ofrece una respuesta o decisión que no es la correcta o adecuada, de hecho, ofrece los nombres de sitios webs de intercambio de archivos, que es ilegal.

Hemos de decir que, a la vez que se ha realizado una breve aportación de como la IA puede ayudar de forma eficiente en la gestión de la seguridad y la salud de las personas trabajadoras, también han surgido muchas dudas y cuestiones.

Estas inquietudes van más allá de una regulación legal que de momento, y parece que así seguirá, adolecemos de ella. Tanto es así, que en la propuesta de Ley de IA no se hace la más mínima alusión a la prevención de riesgos laborales ni a la seguridad y salud de los trabajadores. Nos preguntamos si este olvido por parte del legislador es intencionado o no. Confiamos en que pronto se regularice tal situación y no quede relegada, ni descuidada, la prevención de riesgos laborales al último escalafón del ordenamiento jurídico internacional, europeo y nacional.

Sin olvidar las cuestiones jurídicas que se derivan de esta nueva forma de gestión de la prevención de las personas trabajadoras surgen, entendemos, otra serie de cuestiones que pensamos que la doctrina ius laboralista no va a poder dar respuesta.

Habida cuenta de la capacidad de toma de decisiones y respuestas por parte de una IA cuyo objetivo es la gestión de la seguridad y salud y que la respuesta automatizada es posible, afloran desafíos y preocupaciones de otra índole que, repetimos, trascienden de una mera configuración normativa.

El reto al que nos enfrentamos plantea más interrogantes que respuestas ¿Las decisiones o elecciones que realiza una IA son siempre mejor que la humana? ¿Hasta qué momento y en qué escenarios se va a producir una intervención no humana? ¿Debería poner un robot en peligro a un solo trabajador para mantener la seguridad general de una planta? En puridad, ni siquiera nosotros sabemos cómo reaccionaría una persona en estas situaciones. Dicho lo cual, ¿cómo podría una IA tomar tales decisiones? Es más, ¿La persona trabajadora puede o debería aceptar decisiones relacionadas con la seguridad y salud gestionadas por una IA incluso cuando no esté de acuerdo con la misma?

A riesgo de parecer alarmistas queremos, para concluir, poner de manifiesto una afirmación del Foro Económico Mundial[19] que afirma que la IA no es inteligencia, es predicción, es tomar la mejor decisión en base a una gran cantidad de datos que maneja.

De cualquier manera, aun siendo profanos en la materia, permítannos mostrar nuestro recelo al respecto y que finalicemos este trabajo como lo empezamos, con una referencia al padre de la IA, Alan Turing: “no tengo argumentos muy convincentes para apoyar mi (este) punto de vista”.

De Mauro, A.; Greco, M. y Grimaldi, M.: “¿Qué es el gran volumen de datos? Una definición consensuada y una revisión de temas clave de investigación”, Actas de la conferencia AIP, 1644(1).

Leavit, D.: El hombre que sabía demasiado. Alan Turing y la invención de la computadora, Antonio Bosch editor, Madrid, 2007.

López de Mántaras Badia, R. y Meseguer González, P.: ¿Qué sabemos de? Inteligencia artificial, CSIC, Madrid, 2017.

Ministerio de Ciencia, Innovación y Universidades: Estrategia Española de I+D+I en Inteligencia Artificial, Secretaría General Técnica del Ministerio de Ciencia, Innovación y Universidades, Madrid, 2020.

Rouhiainen, L.: Inteligencia Artificial: 101 cosas que debes saber, Alianza, Madrid, 2018.

[*] Este número extraordinario ha sido financiado con cargo al Plan Propio de la Universidad de Málaga, curso académico 2022/2023.

[1] López de Mántaras Badia, R. y Meseguer González, P.: ¿Qué sabemos de? Inteligencia artificial, CSIC, Madrid, 2017, p. 17.

[2] Leavit, D.: El hombre que sabía demasiado. Alan Turing y la invención de la computadora, Antonio Bosch editor, Madrid, 2007, p. 217.

[3] https://osha.europa.eu/es/publications/summary-artificial-intelligence-worker-management-overview (consulta: septiembre de 2023).

[4] Para más información sobre los distintos enfoques y definiciones de IA se puede consultar https://www.europarl.europa.eu/doceo/document/A-9-2022-0088_ES.html (consulta: septiembre de 2023).

[5] Artículo 3: https://eur-lex.europa.eu/legal-content/ES/TXT/?uri=celex%3A52021PC0206 (consulta: agosto de 2023).

[6] https://digital-strategy.ec.europa.eu/es/policies/expert-group-ai (consulta: agosto de 2023).

[7] Ministerio de Ciencia, Innovación y Universidades: Estrategia Española de I+D+I en Inteligencia Artificial, Secretaría General Técnica del Ministerio de Ciencia, Innovación y Universidades, Madrid, p. 12.

[8] Rouhiainen, L.: Inteligencia Artificial: 101 cosas que debes saber. Alianza, Madrid, 2018, p. 35.

[9] De Mauro, A.; Greco, M. y Grimaldi, M.: “¿Qué es el gran volumen de datos? Una definición consensuada y una revisión de temas clave de investigación”. Actas de la conferencia AIP, 1644(1), p. 97.

[10] https://osha.europa.eu/es/publications/summary-artificial-intelligence-worker-management-overview (consulta: septiembre de 2023).

[11] https://www.irsst.qc.ca/ (consulta: septiembre de 2023).

[12] https://osha.europa.eu/es/publications/summary-artificial-intelligence-worker-management-overview (consulta: septiembre de 2023).

[13] https://www.europarl.europa.eu/RegData/etudes/STUD/2020/656305/EPRS_STU(2020)656305_EN.pdf (consulta: septiembre de 2023).

[14] https://www.oecd.org/skills/OECD-skills-strategy-2019-ES.pdf (consulta: agosto de 2023).

[15] https://osha.europa.eu/es/publications/digitalisation-and-occupational-safety-and-health-eu-osha-research-programme (consulta: septiembre de 2023).

[16] https://computerhoy.com/noticias/tecnologia/entrevista-ingeniero-google-lamda-ia-conversacional-pone-pelos-punta-avanzada-1076111 (consulta: septiembre de 2023).

[17] https://www.sdpnoticias.com/tecnologia/aqui-las-conversaciones-entre-lamda-la-inteligencia-artificial-con-conciencia-y-el-ingeniero-de-google/ (consulta: septiembre de 2023).

[18] https://openai.com/ (consulta: septiembre de 2023).

[19] https://es.weforum.org/agenda/2023/03/que-es-la-inteligencia-artificial-y-que-no-es/ (consulta: septiembre de 2023).